네이버 웹마스터 도구 알아보기 – 진단 편

글쓴이 홈피온

등록일 2022년 6월 15일 09:41

내 사이트를 진단해보자

네이버 서치 어드바이저

2019년에 네이버 웹마스터 도구는

‘네이버 서치 어드바이저 (Naver Search Advisor)’라는 이름으로

개편되었습니다.

네이버 웹마스터 도구 기능 외에도 검색 노출 및 클릭 리포트 기능 등을 추가하여

사이트의 소유자가 좀 더 쉽게

사이트에 대한 관리를 할 수 있도록 하는 내용이 중점이었습니다.

지난 포스팅을 통해

네이버 웹마스터 도구에 대한 이해와 등록을 설명드렸다면

오늘은 진단에 초점을 맞추어 말씀드려보겠습니다.

<네이버 웹마스터 도구 알아보기 – 이해 편 – 바로 가기 ▶>

<네이버 웹마스터 도구 알아보기 – 등록 편 – 바로 가기 ▶>

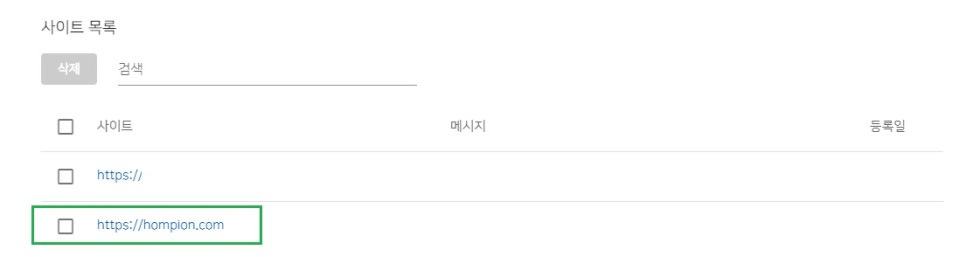

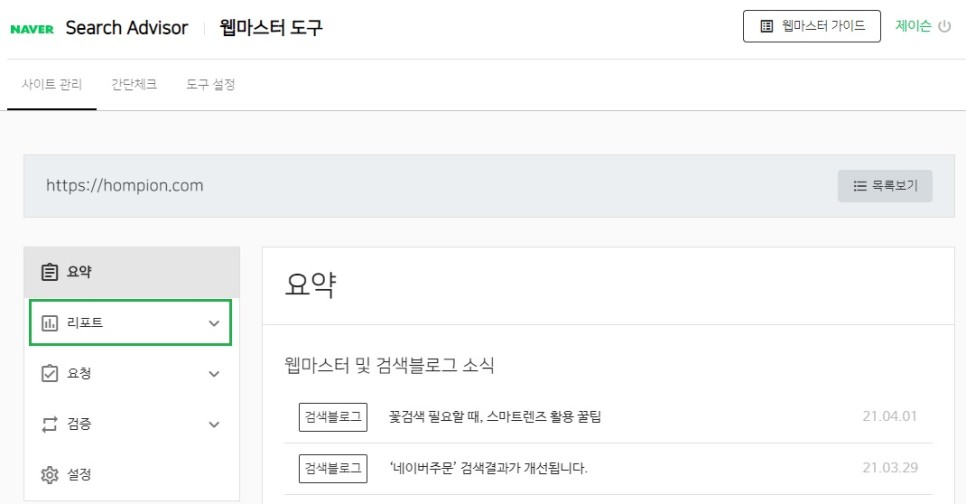

네이버 웹마스터 도구 (서치 어드바이저)에 우선 로그인하신 후,

등록된 사이트 목록에서 사이트를 선택해 주세요.

목록에서 사이트를 선택하시면

내 홈페이지에 대한 네이버 등록 현황 리포트가 보이는데요,

왼쪽 목록에서 2번째인 리포트를 클릭하시길 바랍니다.

리포트의 하위 메뉴 중에서

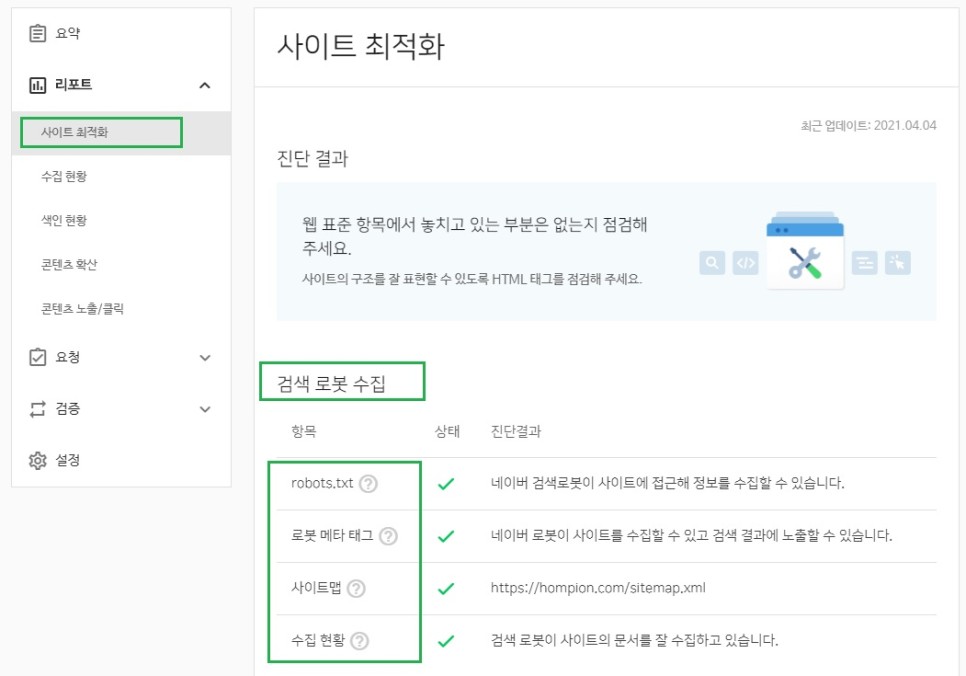

우선 사이트 최적화 부분을 살펴보겠습니다.

네이버 서치 어드바이저에 가장 중요한 부분 중 하나입니다.

먼저 하나의 개념을 잠깐 설명하고 가겠습니다.

웹 표준, (Web Standards)

웹 (사이트, 홈페이지)를 제작할 때

표준적으로 사용되는 기술이나 규칙을 얘기합니다.

웹사이트 제작 과정은 건물 건축 과정에 비유하고 있는데요,

사이트를 제작함에 있어서 그 방법이란 수없이 다양하기 때문에,

그런 다양한 사이트 제작 방법 (소스 구성)에 있어서 표준 규격을 정해놓고

그에 맞춰 여러 내용들을 검증해가는 과정.

정도로 이해해 주시면 좋을 거 같습니다.

웹 표준에 대한 상세한 내용은 추후에 별도로 다루도록 하고

오늘은 간단하게만 여기까지만 하겠습니다.

사이트 최적화 중에 맨 위에 나오는 내용이

‘검색 로봇 수집’에 관련한 내용입니다.

초록색 브이 체크 표시는 원활하다는 의미입니다.

‘robots.txt’는 네이버 검색로봇이 접근할 수 있느냐, 없느냐에 대한 상태 값입니다.

네이버 웹마스터 등록을 할 때

robots.txt 파일을 제작된 사이트 최상단 루트 디렉터리에 위치하게 하는 방식이며,

사이트 제작자에게 요청하시면 쉽게 해결이 될 것입니다.

(또는 네이버 웹마스터 도구의 검증 항목에서 간단한 robots.txt 파일이 생성 가능합니다.)

‘로봇 메타 태그’는 네이버 검색로봇이 사이트 내용을 수집해감으로써

그 내용을 검색 결과에 반영하게 하는데,

사이트 HTML 문서의 <head> 태그 내에 있는 <meta> 태그를 활용하여 제어하게 됩니다.

‘사이트맵’은 ‘sitemap.xml’을 제출하였는지에 표시입니다.

‘수집 현황’ 은 네이버 검색 로봇이 사이트의 내용들을 잘 수집하고 있는지를 표시해 줍니다.

‘robots.txt’, ‘로봇 메타 태그’, ‘사이트맵’을 기반으로 검색 로봇이 더 잘 수집된다는 의미입니다.

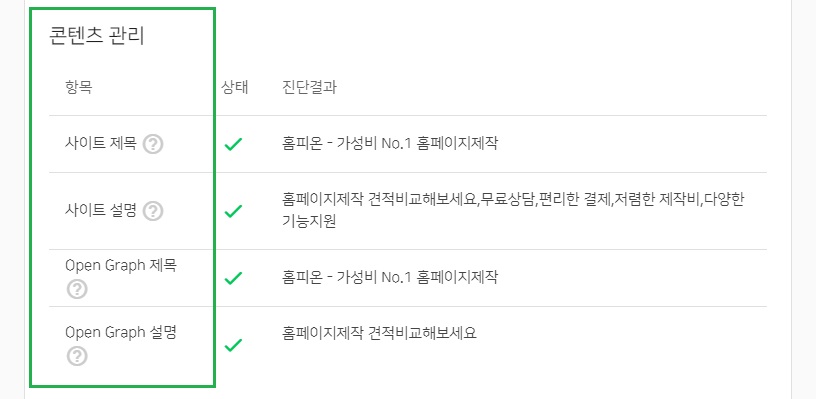

다음으로 ‘콘텐츠 관리 영역’이 나옵니다.

검색엔진 최적화를 위해서는 몇 가지 요소가 필요한데요,

그중에 하나가 되는 좋은 콘텐츠, 남들과 차별화가 되는 콘텐츠 구성에 대한 영역입니다.

사이트의 제목과 설명에 대한 내용을 HTML 문서에 잘 넣었는지를 체크해 주는 것입니다.

특기할만한 것은 ‘open graph’ 라는 내용인데요,

최초에 페이스북에서 시작된 규격으로

URL 공유를 통해 표시되는 사이트 및 콘텐츠의 표시 방식입니다.

일반적인 검색 결과에 영향을 미치는 요소라기보다는

sns 공유 등을 통해 일반 사이트 제목이나 설명 보다 좀 더 깔끔하게 정리된 내용을 노출시키고 싶을 때

활용하는 요소라고 보시면 될 거 같습니다.

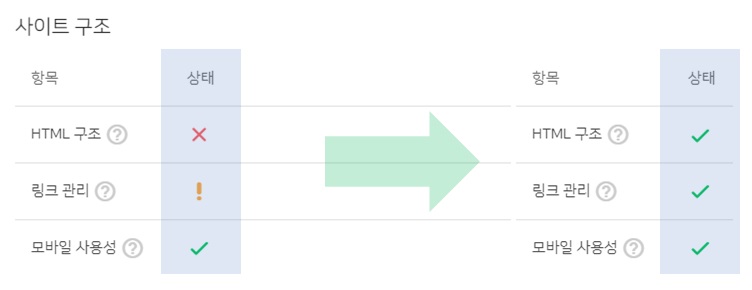

‘사이트 구조’는 사이트 구조와 링크를

얼마나 네이버 검색엔진이 잘 이해할 수 있도록 표현을 했냐를 보여주는 부분입니다.

‘HTML 구성’과 ‘앵커 텍스트 관리’ 등이 핵심적인 내용입니다.

다만, 콘텐츠의 양이나 제작 플랫폼에 따라 현실적으로 관리가 쉽지 않을 수 있습니다.

해당 영역은 네이버 검색엔진 고유값이 반영되며 절대적인 수치는 아니기 때문에,

각 사이트의 특성에 따른 적절한 타협이 필요한 영역이라고 생각됩니다.

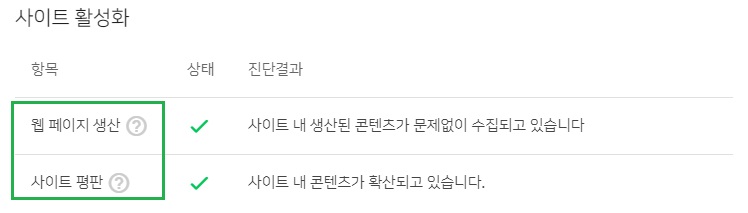

‘사이트 활성화’ 영역입니다.

사이트 내에 존재하는 문서와 링크 등 콘텐츠가 잘 수집되고 있는지,

수집을 통하여 적절한 확산이 이루어지고 있는지를 부여 줍니다.

이제 왼쪽 목록에서 보이는 ‘검증’ 에 대한 내용입니다.

검증은

위에서 설정하고 제출한 내용을 바탕으로

문제없이 웹페이지 수집이 이루어지고 있는지에 대한 ‘자가 진단 툴’ 성격입니다.

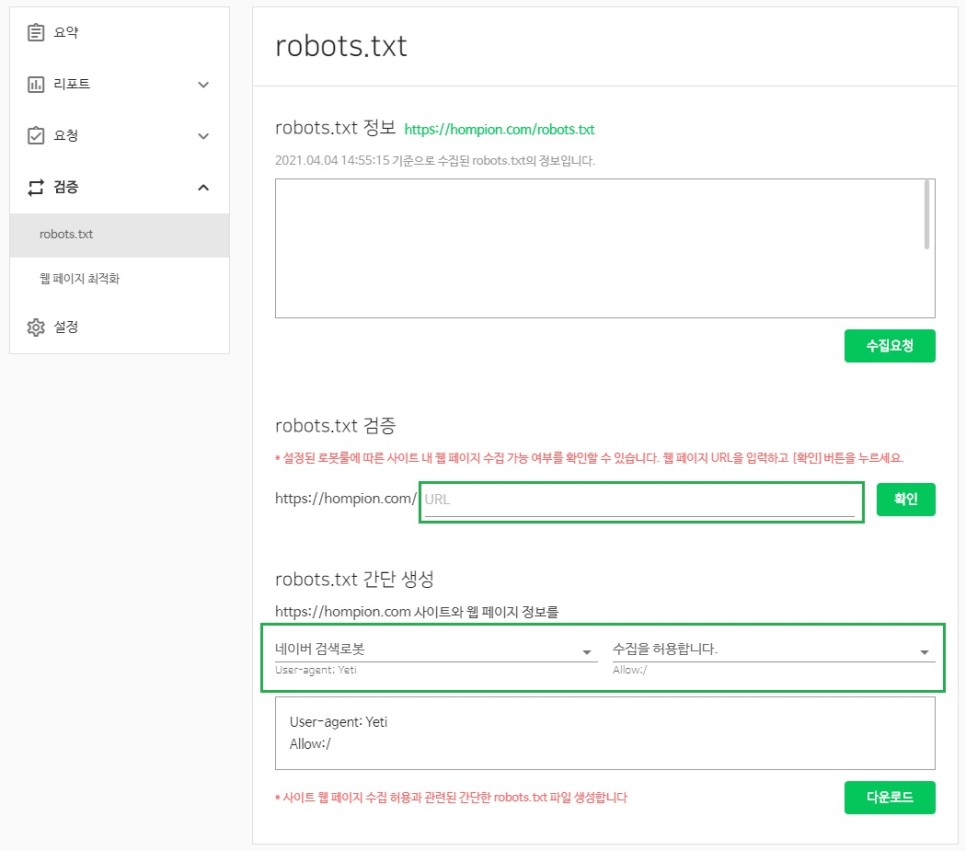

‘robots.txt 정보’ 항목은

검색엔진이 수집해간 robots.txt 파일의 정보 내용을 보여줍니다.

최초에 robots.txt를 문제없이 삽입하셨다면 크게 신경 쓰지 않으셔도 됩니다.

‘robots.txt 검증’ 은

사이트 내 각 페이지들을 문제없이 수집하고 있는지를 확인해 줍니다.

페이지별 상세 URL를 개별로 입력하셔서 체크해보시길 바랍니다.

‘robots.txt 간단 생성’은

웹 페이지 수집 허용에 관련된 간단한 robots.txt 파일을 생성하는 기능입니다.

공식적으로,

네이버는

이러한 사이트 최적화의 내용이 검색 노출 순위와 직접적인 연관이 없다고 하는데요,

굳이 네이버가 싫어하는 사이트 유형으로 방향을 잡을 이유도 없으므로

네이버 검색엔진이 좋아하는 사이트의 유형의 유형을 파악하고

사이트 제작의 방향을 잡는 데 도움이 되시길 바랍니다.

성공적인 사이트 제작을 기원합니다.